- Produkte

- Integrationen

- Preise

- Success Stories

- Ressourcen

- Neustes WhitepaperUnmasking the Shadows: Invalid Traffic 2024

Erfahren Sie alles, was Sie über Invalid Traffic 2024 wissen müssen, basierend auf den Daten unserer Kunden. Einschließlich einer Aufschlüsselung nach Marketingkanälen, Branchen und vielem mehr.

Ressourcen

- Unternehmen

- Unternehmen

- Blog

ChatGPT – Eine neue Ära des Betrugs

Oliver Kampmeier

Cybersecurity Content Specialist

Kaum ein anderes Thema ist in den vergangenen Monaten so präsent wie ChatGPT. Eine künstliche Intelligenz (KI), die in der Lage ist, mit einem Menschen per Text zu kommunizieren, Informationen und Texte zusammenzufassen und gar eigene Texte zu einem Thema zu verfassen.

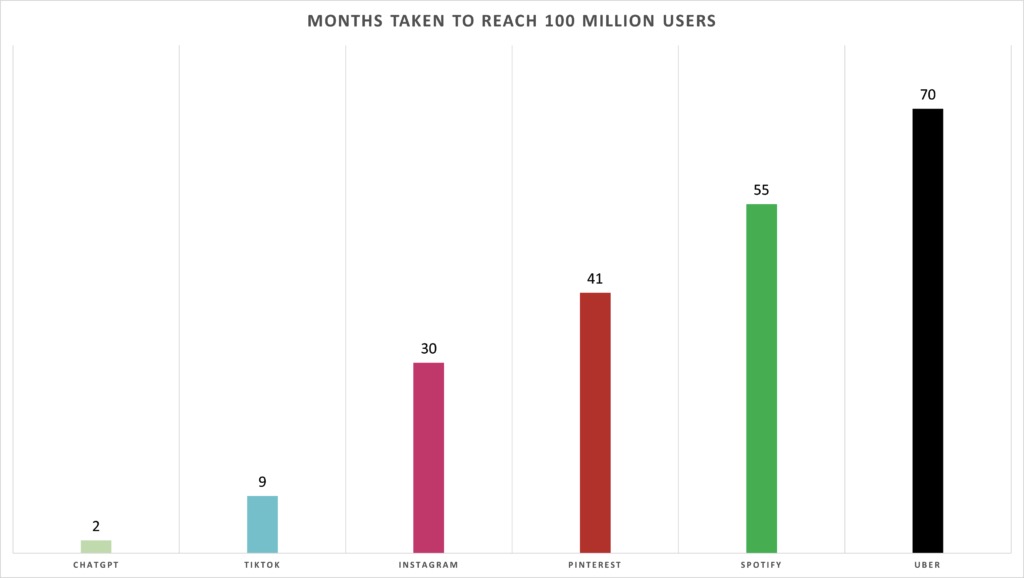

Doch auch aus wirtschaftlicher Sicht ist ChatGPT interessant. Kein anderes Produkt konnte so schnell die magische Grenze von 100 Millionen User knacken. Hat Instagram noch 30 Monate dafür gebraucht, waren es bei TikTok nur noch 9 und bei ChatGPT sagenhafte 2.

Doch so gut es auch klingt, ChatGPT in seinen täglichen Workflow zu integrieren, um viel Zeit in bestimmten Arbeitsabläufen einzusparen, so weitreichend können die Folgen für diese Technologie sein, wenn sie in die falschen Hände gerät.

Im nachfolgenden Artikel wollen wir uns die Einsatzmöglichkeiten von ChatGPT für (Werbe-)Betrug ansehen. Wie wird es bereits aktuell für böswillige Absichten eingesetzt und was wird uns noch in Zukunft erwarten?

ChatGPT und Betrug – die Einsatzmöglichkeiten sind vielfältig

Wir haben bereits an mehreren Stellen angemerkt, dass Betrüger schlaue Leute sind. Sie sind early-adopter neuester Technologien und finden stets Möglichkeiten, diese für ihre Betrugsmaschen einzusetzen. So auch im Falle von ChatGPT. Nachfolgend eine unvollständige Liste an Einsatzmöglichkeiten, wie ChatGPT bereits heute, und damit nur wenige Monate nach offiziellem Release, für Betrug eingesetzt wird.

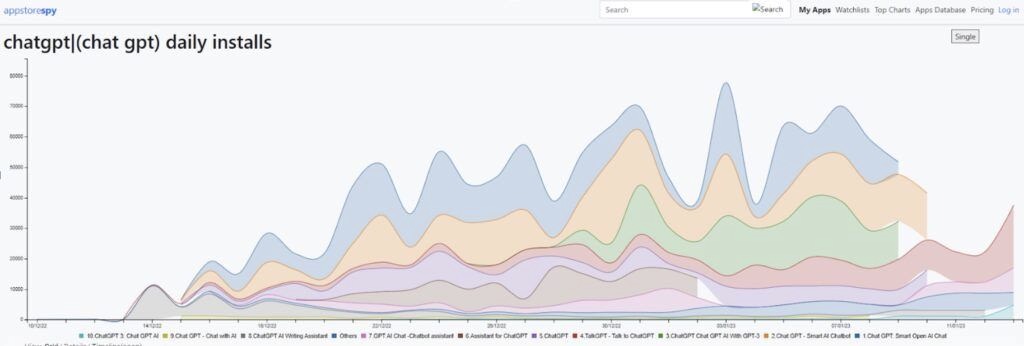

Fake ChatGPT Apps und Websites

Noch bevor OpenAI am 1. März eine API ankündigte, gab es bereits eine Reihe von Apps in den App-Stores, die eine Nutzung von ChatGPT auf dem Smartphone versprachen. Alle haben gemein, dass sie „ChatGPT“ in ihrem Namen verwenden, um so vom Hype und gestiegener Suchanfragen zu profitieren.

Viele Apps haben allerdings nur einen simplen Chatbot integriert und zeigen unentwegt versteckte Werbeanzeigen im Hintergrund an. Andere Apps werden für diverse Malware-Kampagnen eingesetzt, infizieren die Endgeräte der Nutzer und stehlen personenbezogene Informationen wie Passwörter und Kreditkartendaten.

Zusätzlich zu den Fake Apps gibt es auch eine Reihe von Fake Websites, die eine exakte Kopie der offiziellen ChatGPT Website darstellen. Diese Websites versprechen den Besuchern entweder einen Download von ChatGPT – der Dienst steht ausschließlich browserbasiert zur Verfügung – oder fälschen die Zahlungsseite, auf denen sie angeblich ein Upgrade auf ChatGPT Plus vornehmen können. In Wirklichkeit verlieren die User aber ihr Geld und ihre Daten.

Terrorismus, Propaganda und Desinformation

ChatGPT zeichnet sich dadurch aus, dass es schnell und in großem Umfang authentisch klingende Texte produziert. Dies macht das Modell ideal für Propaganda- und Desinformationskampagnen, da es den Betrügern ermöglicht, mit relativ geringem Aufwand Nachrichten zu erstellen und zu verbreiten, die ein bestimmtes Narrativ widerspiegeln.

Hinzu kommt, dass es mittlerweile jedem möglich ist, für wenig Geld ein Sprachmodell mit eigenen Daten und Quellen zu trainieren. Ein mit Fake News trainiertes Sprachmodell wird immer Fake News verbreiten, da es selbst keine andere Realität kennt.

„So wie das Internet Informationen demokratisiert hat, indem es jedem erlaubt hat, Behauptungen online zu veröffentlichen, stellt ChatGPT eine weitere Nivellierung des Spielfelds dar und leitet eine Welt ein, in der jeder, der schlechte Absichten hat, über die Macht einer Armee von erfahrenen Schreibern verfügt, die falsche Geschichten verbreiten.“ (Quelle)

Gepaart mit den Mikro-Targeting-Möglichkeiten sozialer Netzwerke ergibt das eine hochexplosive Mischung für die nächsten Wahlen westlicher Länder.

Social Engineering / Imitation

Nicht nur können Sprachmodelle wie ChatGPT authentisch wirkende Texte produzieren, sie können das auch in einem bestimmten, vorgegebenen Sprachstil. Europol warnt in seinem Paper „ChatGPT – Die Auswirkungen von Large Language Models auf die Strafverfolgung“ sogar explizit vor diesem Einsatzzweck:

„Die Fähigkeit von LLMs, Sprachmuster zu erkennen und nachzubilden, erleichtert nicht nur Phishing und Online-Betrug, sondern kann auch allgemein dazu verwendet werden, den Sprachstil bestimmter Personen oder Gruppen nachzuahmen. Diese Fähigkeit kann in großem Umfang missbraucht werden, um potenzielle Opfer dazu zu verleiten, ihr Vertrauen in die Hände von kriminellen Akteuren zu legen.“ (Quelle)

Abgesehen von Phishing-Attacken, kann diese Fähigkeit beispielsweise auch bei Fake Websites zum Einsatz kommen. Bislang erstellten Betrüger meist eine exakte Kopie einer Landingpage eines Unternehmens, häufig mit Tools wie HTTrack. Durch ChatGPT haben sie jetzt aber die Möglichkeit eine gesamte Website zu fälschen, die durchaus die echte sein könnte, es jedoch nicht ist.

Dadurch täuschen Betrüger sowohl die Besucher als auch Sicherheitssysteme, die in den meisten Fällen nur nach exakten Kopien der echten Seite suchen. Diese Systeme werden schlichtweg durch die geänderten Inhalte ausgehebelt, während gleichzeitig der Anschein einer echten Website bei den Besuchern aufrechterhalten wird.

Phishing & Scam

Einer der wohl naheliegendsten Einsatzmöglichkeiten von ChatGPT im Hinblick auf Betrug sind Texte für Phishing-Mails. Nicht nur wird zukünftig die Qualität von Phishing-Mails durch perfekt geschriebene Texte zunehmen, Betrüger können mithilfe von ChatGPT viel schneller, authentischer und in erheblich größerem Umfang agieren.

„Ein einziger Betrüger kann von seinem Laptop aus überall auf der Welt Hunderte oder Tausende von Betrügereien parallel durchführen, Tag und Nacht, mit Merkmalen auf der ganzen Welt, in allen Sprachen der Welt.“ (Quelle)

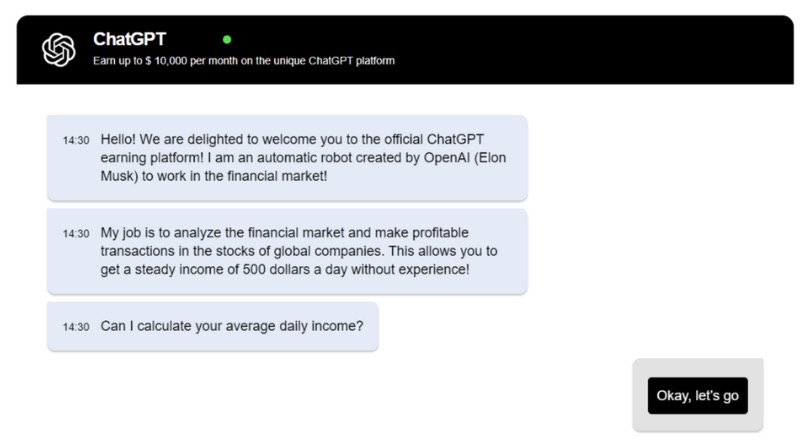

Anfang März machte Bitdefender auf eine neue Phishing-Kampagne aufmerksam, die eine nachgemachte ChatGPT-Plattform nutzt, um leichtgläubige Investoren davon zu überzeugen, ihr Geld in die Plattform zu stecken, um anschließend von den Auszahlungen zu profitieren.

Eine weitere Phishing-Kampagne nutzte die große Entlassungswelle 2022 im Tech-Bereich, um verzweifelte Arbeitnehmer auf der Suche nach einem neuen Job ins Visier zu nehmen. Die Betrüger geben sich als Arbeitgeber oder Personalvermittler aus und sind sehr geschickt darin, ihre Business-Profile (z.B. LinkedIn) legitim aussehen zu lassen.

Haben sie ein Opfer am Haken, verlangen sie nach einiger Zeit nach einer Zahlung für den Kauf eines Laptops und dessen Bankdaten, damit angeblich eine Erstattung des Kaufpreises stattfinden kann. Das Opfer meint also einen neuen Job gefunden zu haben und innerhalb der nächsten Tage einen Laptop samt Erstattung dafür zu erhalten. In Wirklichkeit stehlen die Betrüger das Geld und die personenbezogenen Daten (u.a. Ausweis- und Bankdaten) und sind anschließend für immer verschwunden.

Automatisch generierter schadhafter Code

ChatGPT wurde nicht nur mit Milliarden von Texten trainiert, sondern auch mit unzähligen Zeilen Code. Andere KIs wie Githubs Copilot (oder Copilot X, in welchem GPT-4 integriert ist) wurden ausschließlich mit Code trainiert.

Während diese Tools Entwicklern eine Menge Zeit in ihrer täglichen Arbeit ersparen können, erschaffen sie gleichzeitig ein komplett neues und riesiges Problem: Sie ermöglichen es unerfahrenen Entwicklern, mit einfachen Textanweisungen komplexe Schadsoftware zu erstellen.

„Kurz nach der Veröffentlichung von ChatGPT wurde in einem Blogbeitrag von Check Point Research im Dezember 2022 demonstriert, wie ChatGPT verwendet werden kann, um einen vollständigen Infektionsfluss zu erzeugen, der von Spear-Phishing bis zur Ausführung einer Reverse-Shell reicht, die Befehle in englischer Sprache annimmt.“ (Quelle)

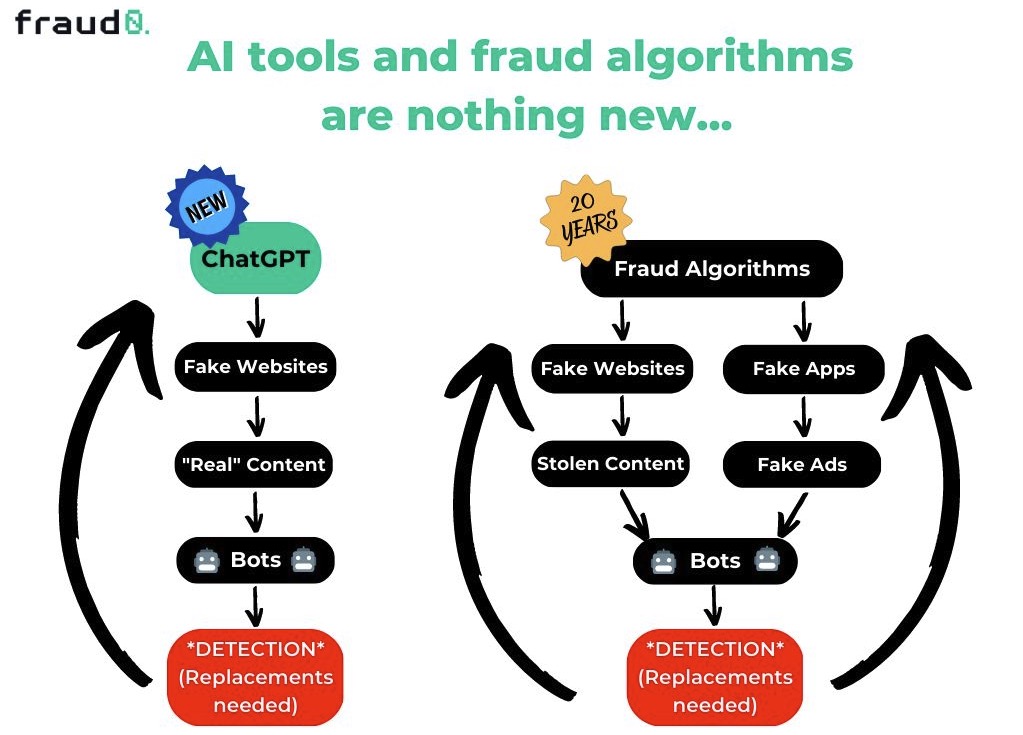

Werbebetrug mit vollautomatisierten Fake Websites

Vereint man alle potenziell schadhaften Einsatzmöglichkeiten von ChatGPT, wird eines schnell klar: Noch nie war es für Betrüger einfacher, sowohl das technische Fundament, den Inhalt als auch das “Marketing” für eine Fake Website oder App vollautomatisiert abzubilden.

Das Raffinierte daran: Diese Fakes müssen keinerlei Kopie einer bestehenden Website oder App sein, sondern können durch eine Kombination verschiedener KIs einzigartigen Inhalt bieten. Die sprachlich perfekten Texte für die Website kommen von ChatGPT, die Bilder von Midjourney oder Dall-E und die Werbebanner, um Besucher auf die Seite zu locken, können mithilfe von Tools wie AdCreative erstellt werden.

De facto nutzen Betrüger schon seit mehreren Jahren verschiedene Tools, um Fake Websites mit plagiierten Inhalten zu erstellen. Doch kamen früher sogenannte „Article Spinner“ Tools zum Einsatz, die in einem vordefinierten Text lediglich einzelne Wörter durch Synonyme ausgetauscht haben. Jetzt haben Betrüger mit Tools wie ChatGPT und Bildgeneratoren wie Midjourney die Möglichkeit einzigartige Inhalte zu erschaffen, die von echten kaum mehr zu unterscheiden sind.

Es ist also nicht verwunderlich, dass es im Internet bereits unzählige Anleitungen gibt, wie man automatisiert eine Website in Verbindung mit ChatGPT erstellt.

Technisch unerfahrene Betrüger können somit noch leichter Fake Sites erstellen, die sie mit Werbeplatzierungen ausstatten. Die Werbeplätze werden anschließend primär über sog. Open Auction Inventare von Werbetreibenden eingekauft.

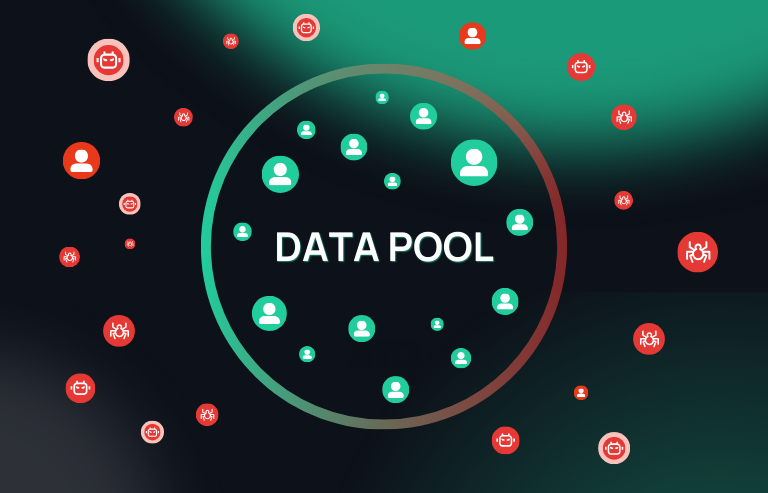

Das Problem dabei: diese Fake Websites werden häufig nie von echten Menschen gesehen, sondern mit Bot-generiertem Traffic monetarisiert. Werbetreibende zahlen also für Werbung an Bots auf von KI automatisch generierten Webseiten.

Unsere Vorhersage: ChatGPT wird Betrügern das Leben erheblich erleichtern

Nachdem wir eine Vielzahl von verschiedenen Anwendungsmöglichkeiten für ChatGPT in Bezug auf (Werbe-)Betrug aufgezeigt haben, möchten wir zum Abschluss eine kleine Prognose wagen.

Wir denken, dass KIs wie ChatGPT Betrügern das Leben erheblich erleichtern werden. Noch nie war es einfacher, automatisiert Texte, Bilder und Code zu erstellen und die einzelnen Bestandteile miteinander zu kombinieren.

Konkret gehen wir von folgenden Dingen aus:

- Mehr Propaganda- und Desinformationskampagnen

Die Aussagen einer künstlichen Intelligenz wie ChatGPT könnten als Maßstab für die Wahrheit verwendet werden. Denn wenn eine Maschine, die auf Milliarden von Texten basiert, etwas sagt, muss es doch stimmen. Besonders in Zeiten eines Wahlkampfs kann dadurch ein enormer Schaden und Vertrauensverlust entstehen. - Bessere Phishing-Kampagnen

Die Qualität hinsichtlich Rechtschreibung und Grammatik von Phishing-Mails wird sich sehr schnell sehr stark verbessern. Dadurch wird es immer schwerer, Scam von echten Mails zu unterscheiden. Auch die E-Mail-Kommunikation zwischen Betrüger und Opfer könnte zukünftig automatisiert werden. Dadurch sinkt der Zeitaufwand der Betrüger enorm und sie können sich darauf fokussieren, noch mehr und noch bessere Phishing-Mails zu entwerfen. - Mehr Fake Websites

Wir gehen auch von einer massiven Zunahme an gefälschten Websites aus, welche für Werbebetrug missbraucht genutzt werden. Diese Seiten tauchen in sog. DSPs (Demand Side Plattformen) auf und werden primär dafür genutzt, Werbung an künstlichen, Bot-generierten Traffic auszuliefern. Grund für die Zunahme: zum einen, ist für technisch unerfahrene Betrüger die Eintrittshürde extrem gesunken und zum anderen haben erfahrene Betrüger jetzt eine Möglichkeit, Webseiten noch echter wirken zu lassen. Auch gehen wir davon aus, dass solche gefälschten Webseiten sich immer mehr in den organischen Suchergebnissen wiederfinden werden. Ein wesentlicher Faktor von ChatGPT ist, dass die Texte zwar auf bereits vorhandenen Inhalten basieren, die generierten Texte allerdings kein „duplicate content“ im klassischen Sinne darstellen, da sie keine 1:1 Kopie sind. Somit wird es einfach für Webseiten, die rein auf KI-generierte Inhalte setzen, organische Rankings in Suchmaschinen zu erzielen. Eine zuverlässige Erkennung, ob Texte mithilfe einer KI erstellt wurden, fehlt heutzutage leider noch.

Wir hoffen, wir konnten Ihnen mit unserem Artikel einen guten ersten Einblick in die Potenziale von ChatGPT in Verbindung mit (Werbe-)Betrug geben und Sie ein wenig für die bevorstehende Zukunft sensibilisieren.

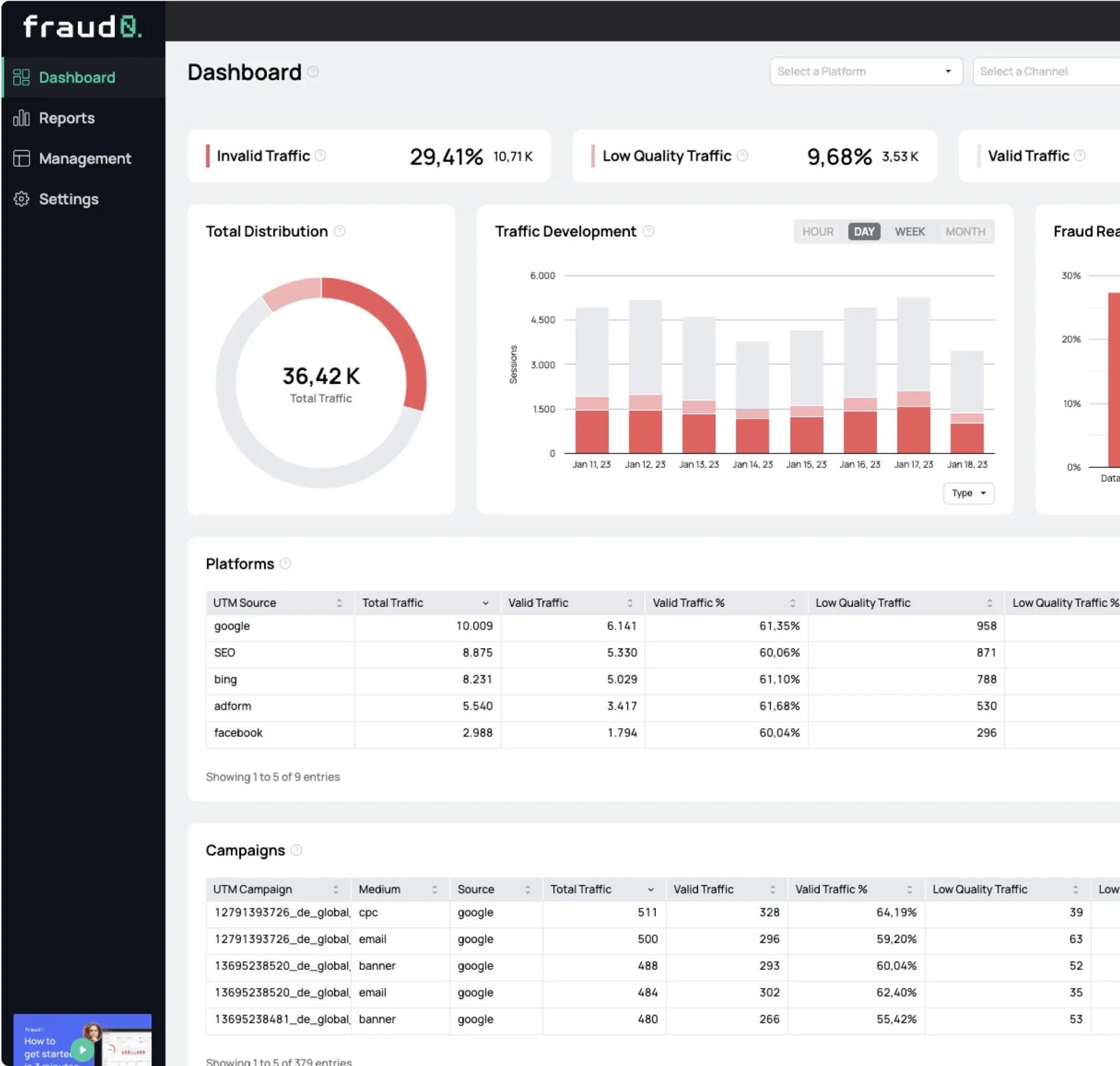

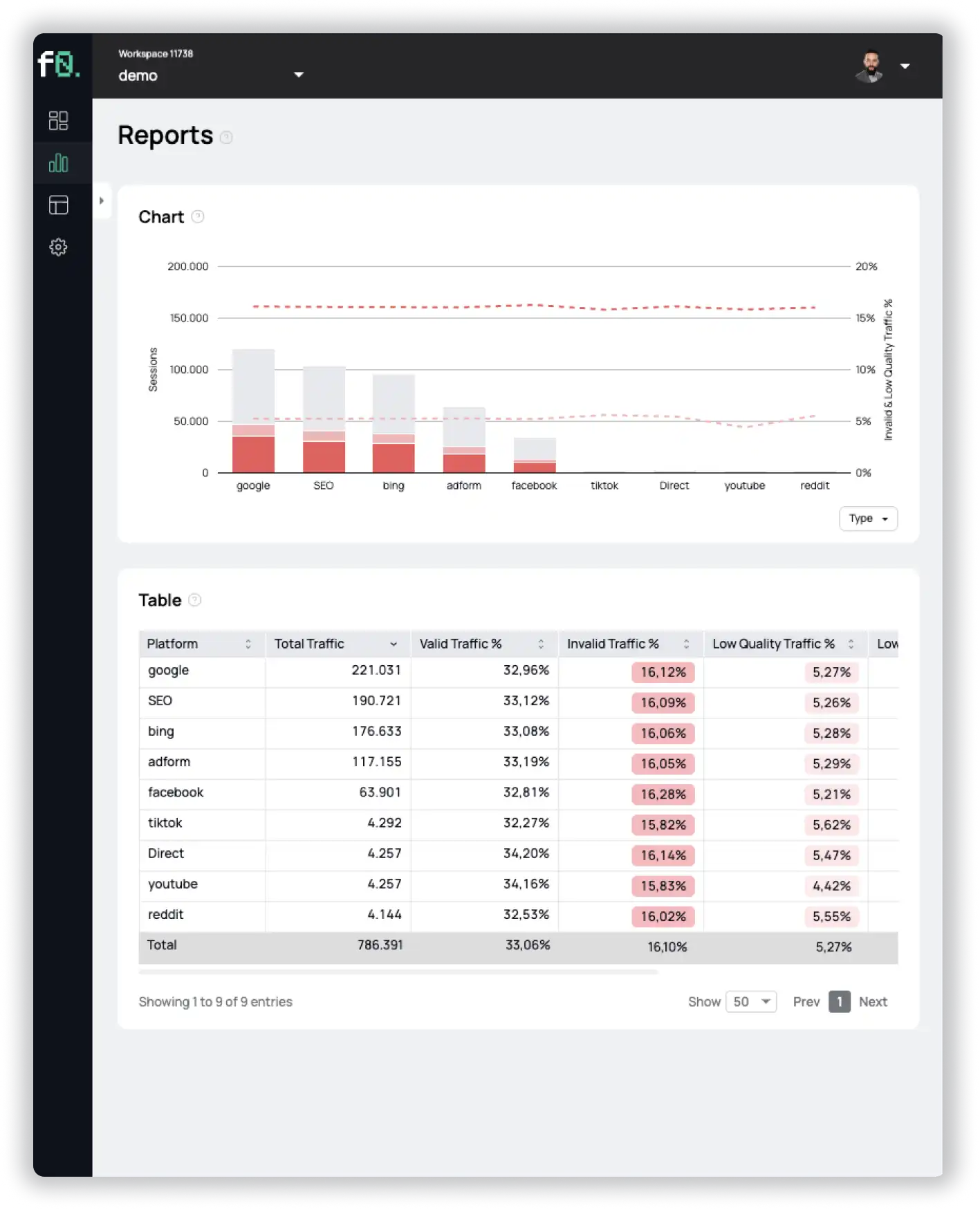

Um Ihr Werbebudget auch weiterhin vor Bots und Fake Websites zu schützen, melden Sie sich für eine kostenlose 7-tägige Testversion von fraud0 an.

- Veröffentlicht: April 12, 2023

- Aktualisiert: November 28, 2023

Erfahren Sie alles, was Sie über Invalid Traffic 2024 wissen müssen, basierend auf den Daten unserer Kunden. Einschließlich einer Aufschlüsselung nach Marketingkanälen, Branchen und vielem mehr.

1%, 4%, 36%?