- Blog

Fake Future #1: Deepfake videos

Oliver Kampmeier

Cybersecurity Content Specialist

Wir sind gerne auf der Höhe der Zeit. Ob es um neue Methoden des Werbebetrugs, Bot Traffic oder neue Technologien geht, die das Potenzial haben, die Welt zu verändern.

Eine dieser Technologien sind Deepfakes. Meistens handelt es sich dabei um kurze Videos, die im Social-Media-Feed angezeigt oder von jemand anderem weitergeleitet werden – Ja, Mama, ich habe Tom Cruises verrückten Kanal auf TikTok gesehen, und ich kann es selbst nicht glauben.

Dieser Artikel ist Teil einer dreiteiligen Serie über Deepfakes, die jeweils eine bestimmte Form von Deepfake behandelt. Mit dieser Artikelserie wollen wir Sie auf eine Reise in computergenerierte Bilder und Videos mitnehmen, die zum Teil sehr verrückt sind und ernsthafte Auswirkungen auf die Menschheit haben könnten.

In diesem Artikel geht es um Deepfake-Videos, was sie sind, wie sie erstellt werden und welche Auswirkungen diese Technologie auf die Gesellschaft insgesamt haben kann.

Was sind Deepfakes?

Deepfakes nutzen eine Form der künstlichen Intelligenz, die als Deep Learning bezeichnet wird, um gefälschte Bilder, Audio- oder Videodaten zu erstellen – daher der Name Deepfake. Deep-Learning-Algorithmen sind in der Lage, sich selbst beizubringen, wie sie Probleme lösen können, wenn sie eine große Menge an Daten erhalten.

Selbst für den unwahrscheinlichen Fall, dass Ihnen der Name nicht geläufig ist, ist die Wahrscheinlichkeit groß, dass Sie bereits ein Deepfake-Video gesehen haben. Zu den bekanntesten Videos gehören:

- Obama nennt Donald Trump einen Vollidioten

- Präsident Nixon, der die „In Event of Moon Disaster“-Rede hält, in der Neil Armstrong und Edwin Aldrin von ihrer Mondmission nicht zurückkehren.

- Mark Zuckerberg schwärmt von seiner Weltherrschaft

Wie werden Deepfakes erstellt?

Video- und Bildmanipulationen gibt es schon seit mehreren Jahrzehnten. Es war im Jahr 2017, als ein User namens „deepfakes“ manipulierte Filme für Erwachsene auf Reddit postete. In dem Video wurden die Gesichter der Schauspielerinnen mit denen von Berühmtheiten wie Taylor Swift und Gal Gadot vertauscht.

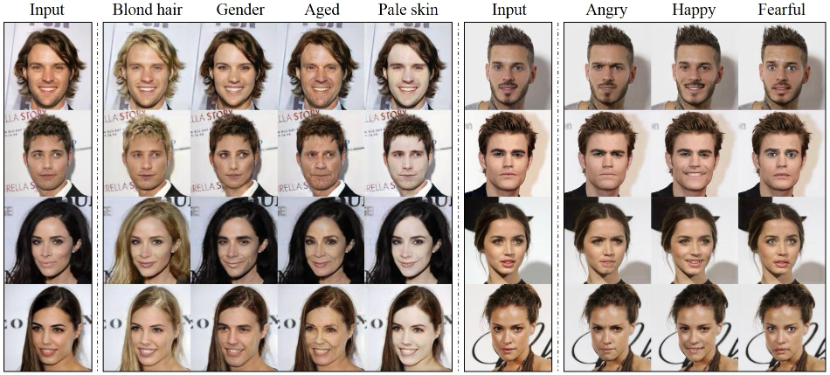

Aber wie genau tauscht man die Gesichter von Personen in einem Video aus? Es gibt mehrere Techniken, die Algorithmen des maschinellen Lernens verwenden, um diese Aufgabe zu bewältigen. Sie basieren auf Autoencodern und manchmal sogar auf anspruchsvolleren Generative Adversarial Networks (GANs). Beide haben gemeinsam, dass sie zunächst auf einem Datensatz trainiert werden müssen, um einen Teil des Gesichts einer Person ersetzen zu können.

Für den Anfang brauchen Sie Daten – eine Menge Daten. Man braucht Bilder vom Gesicht der Person, die man mit einer anderen austauschen möchte. Um das Ergebnis zu verbessern, benötigen Sie mehrere tausend dieser Bilder in allen Szenarien wie Hell- und Dunkelbelichtung, Frontal- und Seitenansicht und auch mit verschiedenen Gesichtsausdrücken. Bei Prominenten ist das leichter zu realisieren, weil Tausende von Bildern von ihnen im Internet, in verschiedenen Fotodatenbanken und durch Interviews verfügbar sind.

AUTOENCODER

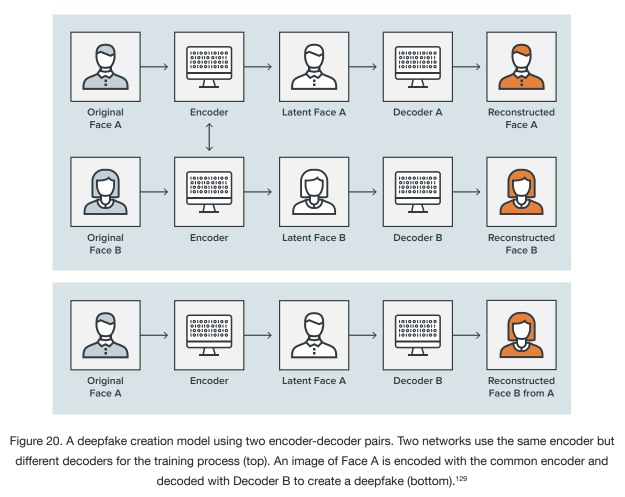

Um es so einfach wie möglich zu halten: Autoencoder sind eine Familie von selbstüberwachten neuronalen Netzen, die lernen, ihre Eingaben zu replizieren. Sie bestehen aus drei Hauptkomponenten: einem Encoder, einem Code und einem Decoder.

Der Encoder sucht nach Ähnlichkeiten zwischen den beiden Gesichtern, die Sie austauschen möchten, und reduziert sie auf ihre gemeinsamen Merkmale. Er komprimiert die Eingabedaten und erzeugt den Code, den der Decoder im weiteren Verlauf verwendet.

Nachdem der Encoder mit seiner Arbeit fertig ist, übernimmt der Decoder die Aufgabe. Dieser Algorithmus ist darauf trainiert, Gesichter aus den komprimierten Bildern wiederherzustellen, die vom Encoder erzeugt wurden. Sie müssen zwei verschiedene Decoder trainieren: einen, der das Gesicht der ursprünglichen Person wiederherstellt, und einen, der das Gesicht wiederherstellt, das Sie ersetzen möchten.

Alles, was Sie jetzt tun müssen, ist, die komprimierten Bilder in den „falschen“ Decoder einzuspeisen: Das Gesicht der Originalperson wird in den Decoder eingespeist, der auf das Gesicht der Person trainiert wurde, die Sie austauschen wollen – die „Fälschung“. Der Decoder ist dann in der Lage, das „falsche“ Gesicht mit dem Ausdruck und der Ausrichtung des Gesichts der Originalperson zu rekonstruieren.

GENERATIVE ADVERSARIAL NETWORKS (GANS)

Die zweite Methode zur Erstellung von Deepfakes ist die Verwendung von Generative Adversarial Networks. Bei diesem Ansatz treten zwei verschiedene neuronale Netze gegeneinander an: der Generator und der Diskriminator.

Der Generator lernt selbstständig, Regelmäßigkeiten und Muster in einem Eingabedatensatz zu reproduzieren. Diese reproduzierten Daten werden dann zusammen mit echten Daten zur Auswertung an den Diskriminator gesendet.

Der Diskriminator sieht sich die Daten an und versucht, die vom Generator reproduzierten „gefälschten“ Daten innerhalb des Datensatzes zu erkennen und gibt eine Rückmeldung über die Leistung. Der Zweck des Generators ist es, den Diskriminator zu täuschen, so dass er nicht mehr zwischen echten und reproduzierten Daten unterscheiden kann.

Das Hin und Her zwischen dem Generator und dem Diskriminator wird unzählige Male wiederholt, wobei das Ergebnis mit jedem Zyklus besser wird, bis der Generator realistische Gesichter von nicht existierenden Personen erzeugt und damit den Diskriminator erfolgreich täuscht.

Aufgrund des erhöhten Aufwands für das Training der Modelle und des Bedarfs an mehr Rechenressourcen werden GANs häufig nur zur Erstellung von Fotos und nicht von Videos verwendet.

Im folgenden Video sehen Sie, wie man ein komplettes Deepfake-Video mit dem Gesicht von Tom Cruise erstellt:

Geht es bei Deepfakes nur um Videos?

Nein. Die Deepfake-Technologie kann auch fiktive Fotos und Klone von Stimmen von Grund auf erstellen.

Ein Beispiel für fiktive Fotos wäre die Website this-person-does-not-exist.com, die real aussehende Fotos von Personen zeigt, die nicht existieren. Die KI wurde an Tausenden von Profilbildern trainiert und weiß, wie sie realistische Gesichter zeichnen kann. Diese Bilder werden dann z. B. von betrügerischen Unternehmen auf LinkedIn verwendet, um gefälschte Profile zu erstellen, um ihre Vertriebsmitarbeiter zu steigern und Algorithmen zu umgehen, die die Sichtbarkeit einschränken könnten.

Laut seines jüngsten Transparenzreports hat LinkedIn im Jahr 2021 über 30 Millionen Fake-Accounts entfernt, einige davon aufgrund von computergenerierten Profilbildern.

Ein weiteres Beispiel für ein Deepfake-Audio wurde in Disneys Serie The Mandalorian umgesetzt. Mit einer Anwendung namens Respeecher konnte das Filmteam die Stimme des jungen Luke Skywalker vollständig klonen. Die KI wurde mit früheren Radiosendungen und Interviews mit der Stimme von Mark Hamill trainiert, um die gewünschten Ergebnisse zu erzielen. Die Ergebnisse waren so gut, dass sie über 9 Monate lang zwischen der Veröffentlichung von Staffel 2 und der begleitenden Dokumentation unbemerkt blieben.

Welche Technologie braucht man, um Deepfake-Videos zu erstellen?

So schwierig und kompliziert das Erstellen eines Deepfake-Videos auch klingen mag, in Wahrheit ist es sehr einfach. Mit dem technologischen Fortschritt werden Computer immer schneller, so dass es heutzutage sogar möglich ist, ein solches Video zu Hause zu erstellen. Alles, was Sie brauchen, ist ein halbwegs leistungsfähiger Computer mit einer schnellen Grafikkarte. Für anspruchsvollere Videos gibt es auch Cloud-basierte Datenzentren, die Ihnen mehr Leistung bieten.

Auch müssen Sie die entsprechenden Modelle und Algorithmen nicht selbst entwickeln, sondern können auf frei verfügbare Open-Source-Software zurückgreifen:

Alles, was Sie brauchen, sind grundlegende Programmierkenntnisse, um die Tools in Gang zu bringen und die entsprechenden Parameter einzustellen.

Aber heutzutage braucht man nicht einmal mehr einen Computer. Sie können Deepfake-Videos auch mit Ihrem Smartphone erstellen. Es gibt einige Apps, mit denen Sie Ihr Gesicht in Memes und sogar in Videos in sozialen Medien bearbeiten können:

Wofür werden Deepfake-Videos verwendet?

Wie bei so vielen Technologien ist es nicht verwunderlich, dass auch Deepfake-Videos ihre erste Verbreitung in der Pornoindustrie fanden. Gesichter von weiblichen Berühmtheiten, darunter Emma Watson, Jennifer Lawrence und Daisy Ridley, wurden auf Schauspielerinnen platziert.

In der nächsten Phase wurden auch Frauen einbezogen, die mit Staatschefs verschiedener Länder in Verbindung gebracht werden, wie Michelle Obama oder Kate Middleton.

Nach nackten Prominenten waren Politiker die nächste Zielgruppe von Fake-Videos. Das wohl bekannteste Video stammt von Buzzfeed, in dem Präsident Barack Obama Donald Trump einen Vollidioten nennt. In einem anderen Video, das zugegebenermaßen durch den Mund und die Synchronisation sofort als Fake zu erkennen ist, macht sich Donald Trump über die Mitgliedschaft Belgiens im Pariser Klimaabkommen lustig.

Der jüngste politische Skandal im Zusammenhang mit Deepfakes betraf die Berliner Bürgermeisterin Franziska Giffey, die offenbar einen Videoanruf mit einer Fälschung des Kiewer Bürgermeisters Vitali Klitschko führte.

Aber werden alle Deepfake-Videos zu bösartigen Zwecken erstellt? Definitiv nicht! Im Folgenden sind einige Anwendungsfälle für Deepfakes aufgeführt. Einige sind moralisch bedenklich, wie die oben genannten, andere nutzen die neue Technologie zur Unterhaltung und sogar zur Bildung.

KUNST

Das Dali-Museum in St. Petersburg, Florida, nutzte die Deepfake-Technologie, um den „Meister des Surrealismus“ wieder zum Leben zu erwecken. Anhand von über 6.000 Bildern von ihm und mehr als 1.000 Stunden Training lernte die künstliche Intelligenz bis ins Detail, wie er aussah und wie sich sein Mund und seine Augen bewegten.

Das Ergebnis sind 45 Minuten neues Filmmaterial, das in 125 Kurzvideos unterteilt ist, die sich die Besucher ansehen können. Mit 190.512 möglichen Kombinationen sind die Erfahrungen der Besucher praktisch einzigartig. Eine eingebaute Kamera macht auch Selfies mit Dali möglich.

Dies ist ein hervorragendes Beispiel dafür, wie KI und insbesondere Deepfakes den Menschen nicht nur Unterhaltung und unvergessliche Erlebnisse bieten können, sondern wie diese Technologie auch für einen pädagogischen und sinnvollen Zweck eingesetzt werden kann.

FILM-/MEDIENINDUSTRIE

Wahrscheinlich haben Sie schon einmal einen Film gesehen, in dem die Deepfake-Technologie eingesetzt wurde. Am häufigsten werden Deepfakes eingesetzt, wenn die Schauspieler bereits verstorben sind. Das war bei Carrie Fisher oder Peter Cushing der Fall, die beide in „Star Wars: Rogue One“ auftraten. Es gibt auch Pläne, James Dean für einen neuen Film wiederauferstehen zu lassen.

Ein weiteres Beispiel für die Anwendung in der Filmindustrie ist die Verjüngung von Schauspielern. In „The Irishmen“ haben Robert De Niro, Al Pacino und Joe Pesci ein Facelifting erhalten.

Sind Deepfakes sogar in der Lage, menschliche Schauspieler in Zukunft vollständig zu ersetzen? Wer weiß, aber wahrscheinlich nicht vollständig. Das Beispiel des südkoreanischen Senders MBN zeigt jedoch, dass es durchaus möglich ist, eine Person vollständig zu ersetzen.

Letztes Jahr wurde die Nachrichtensprecherin Kim Joo-Ha während einer Sendung durch ein Deepfake von sich selbst ersetzt. MBN hat bereits zugegeben, dass sie das System auch in Zukunft für Eilmeldungen nutzen wollen.

ANONYMITÄT

Um die Identität homosexueller Tschetschenen zu schützen, deren sexuelle Orientierung in ihrem Heimatland zu Folter und Tod führen kann, haben die Filmemacher in der HBO-Dokumentation „Welcome to Chechnya“ aus dem Jahr 2020 Deepfakes verwendet. Anstelle der traditionellen anonymen Silhouetten-Interviews erhalten die Zuschauer einen intimen Einblick in das Leben homosexueller Tschetschenen, die vor einer Verfolgung fliehen. Ohne die Deepfake-Technologie wäre eine solche Dokumentation weniger fesselnd und bewegend gewesen.

ERPRESSUNG

Natürlich wird eine solche Technologie bereits von Betrügern genutzt, um Menschen zu erpressen. In einem Fall erstellten die Betrüger gefälschte Profile auf Online-Dating-Seiten und gaben sich als Frauen aus. Dann schickten sie Freundschaftsanfragen an Männer und überredeten sie zu einem Videoanruf. Während des Gesprächs wurde ein computergeneriertes Video einer Frau verwendet, um das Opfer zur Selbstbefriedigung zu verleiten. Die Betrüger nahmen natürlich alles auf, und das Opfer erhielt anschließend einen Erpressungsanruf.

Wenn sich das Opfer weigert zu zahlen, beginnt Phase 2. Die Betrüger verwenden ein Foto des Opfers, das während des Videoanrufs aufgenommen wurde, und produzieren ein zweites gefälschtes Video, das das Opfer bei einem sexuellen Akt zeigt. Der Betrug geht also weiter.

MODEINDUSTRIE

Modeunternehmen stehen derzeit vor einem großen Problem: Neue Produkte müssen so schnell wie möglich aus der Planungsphase auf den Markt gebracht werden, um die Follower der Fast Fashion zu befriedigen. Allein die Zeit für die Erstellung von Fotoshootings der Kleidungsstücke kann einige Wochen in Anspruch nehmen. Es müssen Models gecastet, Stylisten gefunden, Fotografen engagiert und alle Kleidungsstücke physisch an einem Ort vorhanden sein, damit das Shooting stattfinden kann.

Aber auch hier könnten Deepfakes eine Lösung bieten. Looklet bietet virtuelle Modelle, die beliebige Kleidung in verschiedenen Posen tragen können. Der Hersteller muss nur noch jedes Teil auf einer Schaufensterpuppe fotografieren und das Bild hochladen. Unabhängig vom Produktionsstandort oder anderen Dienstleistern. Die Hersteller können aus einer Vielzahl verschiedener Modelle – darunter auch Kinder- und Übergrößenmodelle – wählen und ihre Stücke schnell und einfach auf ihrer Website präsentieren.

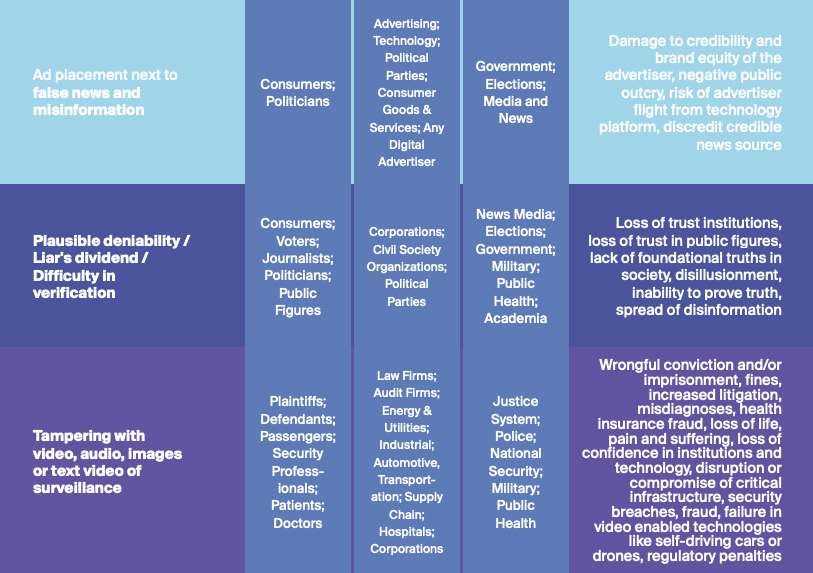

POTENZIELLE BEDROHUNGEN DURCH DEEPFAKE-VIDEOS

Obwohl die Deepfake-Technologie viele legitime Anwendungsfälle hat, gibt es auch potenzielle Gefahren, die von ihr ausgehen können. Europol und UNICRI haben mehrere Szenarien möglicher künftiger Bedrohungen durch Deepfakes ermittelt. Dazu gehören:

- Desinformationskampagnen

- Wertpapierbetrug

- Erpressung

- Online-Verbrechen gegen Kinder

- Behinderung der Justiz

- Kryptojacking

- Illegale Märkte

Weitere Informationen und Beispiele für jedes Szenario finden Sie im vollständigen Report hier.

Ein anderer lesenswerter Report der Deeptrust Alliance listet ebenfalls potenzielle Bedrohungen für Einzelpersonen und Organisationen auf. Eine dieser Bedrohungen ist die Platzierung von Werbung in Verbindung mit Fake News.

Wie erkennt man ein Deepfake-Video?

Da Deepfake-Algorithmen immer besser darin werden, realistische Videos zu erstellen, wird es immer schwieriger, sie von echten Videos zu unterscheiden. Ironischerweise könnte künstliche Intelligenz die Antwort auf die Erkennung gefälschter Videos sein, die von einer anderen KI erstellt wurden.

Die KI kann Anzeichen und Ungereimtheiten im Video erkennen, die nicht echt sind und vom menschlichen Auge leicht übersehen werden könnten. Vor ein paar Jahren war ein ungewöhnliches Blinzeln der Augen ein gutes Zeichen für ein Deepfake-Video. Doch kaum war die Forschungsarbeit veröffentlicht, wurden die Algorithmen verbessert und konnten das Blinzeln realistisch darstellen.

Achten Sie auf die folgenden Anzeichen, um zu erkennen, ob ein Video gefälscht ist oder nicht:

- Belichtung ist falsch

- Seltsame Schatten

- Farbverschiebungen bei der Hautfarbe oder unwirkliche Hautfarbe

- Unstimmigkeiten beim Sprecher

- Ruckartige Bewegungen

- Zusätzliche Pixel

- Mehrfache Lichtreflexion in den Augen

Da eine manuelle Prüfung nicht nur sehr fehleranfällig, sondern aufgrund der großen Menge an Deepfake-Videos auch unpraktisch wäre, muss eine technische und automatisierte Lösung gefunden werden. Einige internationale Unternehmen, Universitäten und Regierungen haben bereits den Hackathon für Frieden, Gerechtigkeit und Sicherheit im Jahr 2019 veranstaltet, um genau dieses Problem zu lösen.

Microsoft, Facebook und Amazon veranstalteten auch einen gemeinsamen Wettbewerb zur Erkennung von Deepfakes, um eine Lösung zur automatischen Erkennung von Deepfake-Videos zu finden. Leider ließen die Ergebnisse noch sehr zu wünschen übrig. Das beste Modell hatte nur eine Erkennungsrate von 65 % – zu schlecht, um derzeit produktiv genutzt zu werden.

Dennoch gibt es heutzutage einige Tools und Techniken, die sich des Problems angenommen haben und ihre Modelle ständig verbessern:

- Sie können fragwürdige Videos online mit deepware.ai scannen, um herauszufinden, ob sie synthetisch manipuliert sind

- Microsoft arbeitet an der Bekämpfung von Desinformation, aber das Tool ist derzeit nicht öffentlich zugänglich

- Forscher sind in der Lage, biologische Signale aus dem Video zu erkennen und gefälschte Herzschläge zu entdecken

- Durch die Analyse von Lichtreflexionen in den Augen kann ein Tool feststellen, ob ein Video ein Deepfake ist oder nicht

- Eine andere Technik macht sich die Tatsache zunutze, dass Viseme, die die Dynamik der Mundform bezeichnen, manchmal von gesprochenen Phonemen abweichen oder mit diesen nicht übereinstimmen.

- Operation Minerva ist ein System, das Deepfake-Pornos erkennen und automatisch eine Benachrichtigung zur Löschung senden kann

- und viele mehr

Derzeit gibt es keine technische Lösung, mit der sich wirksam und zuverlässig erkennen lässt, ob ein Video gefälscht ist oder nicht. Wie bei so vielen anderen Technologien wird es auch hier ein Kopf-an-Kopf-Rennen geben. Auf der einen Seite gibt es Entwickler, die Modelle trainieren, um möglichst realistische Ergebnisse zu liefern und Erkennungsmechanismen zu überlisten. Auf der anderen Seite stehen Forscher, Regierungen und große Plattformen, die gefälschte Videos zuverlässig erkennen und ihre potenziell gefährliche Verbreitung verhindern wollen.

Was sagt das Gesetz zu Deepfake-Videos?

Die Erstellung von Deepfake-Videos ist an sich nicht illegal. Allerdings gibt es einige Länder, die aktiv gegen die Verbreitung von Deepfakes vorgehen. China hat beispielsweise Anfang 2022 ein Gesetz verabschiedet, das es großen Plattformen wie TikTok, die große Datenmengen zur Personalisierung ihrer Inhalte verwenden, untersagt, den Usern gefälschte Videos in ihrem Newsfeed anzuzeigen. Die Vorschriften zielen auf die Verbreitung von Falschinformationen ab, die zu Betrug oder sozialer Instabilität führen könnten.

Ein weiteres Beispiel sind Texas und Kalifornien. Beide Staaten haben politisch motivierte Deepfake-Videos innerhalb von 30 Tagen vor einer Wahl verboten. Außerdem hat Kalifornien, ähnlich wie Virginia, auch Deepfake-Pornografie verboten.

Das größte Problem dürfte jedoch die fehlende Zuständigkeit für extraterritoriale Urheber von Deepfakes sein. Es kann noch so viele Gesetze geben, wenn sie für den Urheber der Videos nicht gelten, weil er sich in einem anderen Land befindet.

“Daher können Unterlassungsklagen gegen Deepfakes nur unter bestimmten Umständen erlassen werden, darunter Obszönität und Urheberrechtsverletzungen.” (Quelle)

Wie sieht die Zukunft von Deepfakes aus?

Ähnlich wie bei den computergenerierten Bildern (CGI) in den frühen 90er Jahren handelt es sich bei Deepfakes um eine bahnbrechende Technologie, die jedoch ein größeres Missbrauchspotenzial aufweist. Manche sagen sogar, dass Deepfakes Chaos anrichten und Vertrauen untergraben werden.

Viele Unternehmen arbeiten bereits an Deepfake-Modellen, die keine großen Datenmengen als Input benötigen, sondern mit nur einem einzigen Bild arbeiten können. Samsung hat es zum Beispiel geschafft, die Mona Lisa mit seiner Technologie zum Leben zu erwecken.

Andere Unternehmen, wie Synthesia, arbeiten an einem Komplettpaket. Dabei wird künstliche Intelligenz eingesetzt, um aus reinen Textdokumenten Videos mit Sprechern und Sprachausgabe zu erzeugen. Die Kunden können aus einer Reihe von verschiedenen Sprechern mit unterschiedlichen Dialekten wählen oder sich bei Bedarf selbst als virtuellen Avatar erstellen. Danach muss nur noch der Text im Video gesprochen werden und das System erledigt den Rest von selbst.

Es wird auch interessant sein zu sehen, wie verschiedene Regierungen auf die potenzielle Bedrohung reagieren und mit der Technologie in Zukunft umgehen werden.

Was auch immer die Zukunft für Deepfakes bereithält, eines ist sicher: Deepfake-Videos sind gekommen, um zu bleiben.

- Veröffentlicht: Juli 1, 2022

- Aktualisiert: November 28, 2023

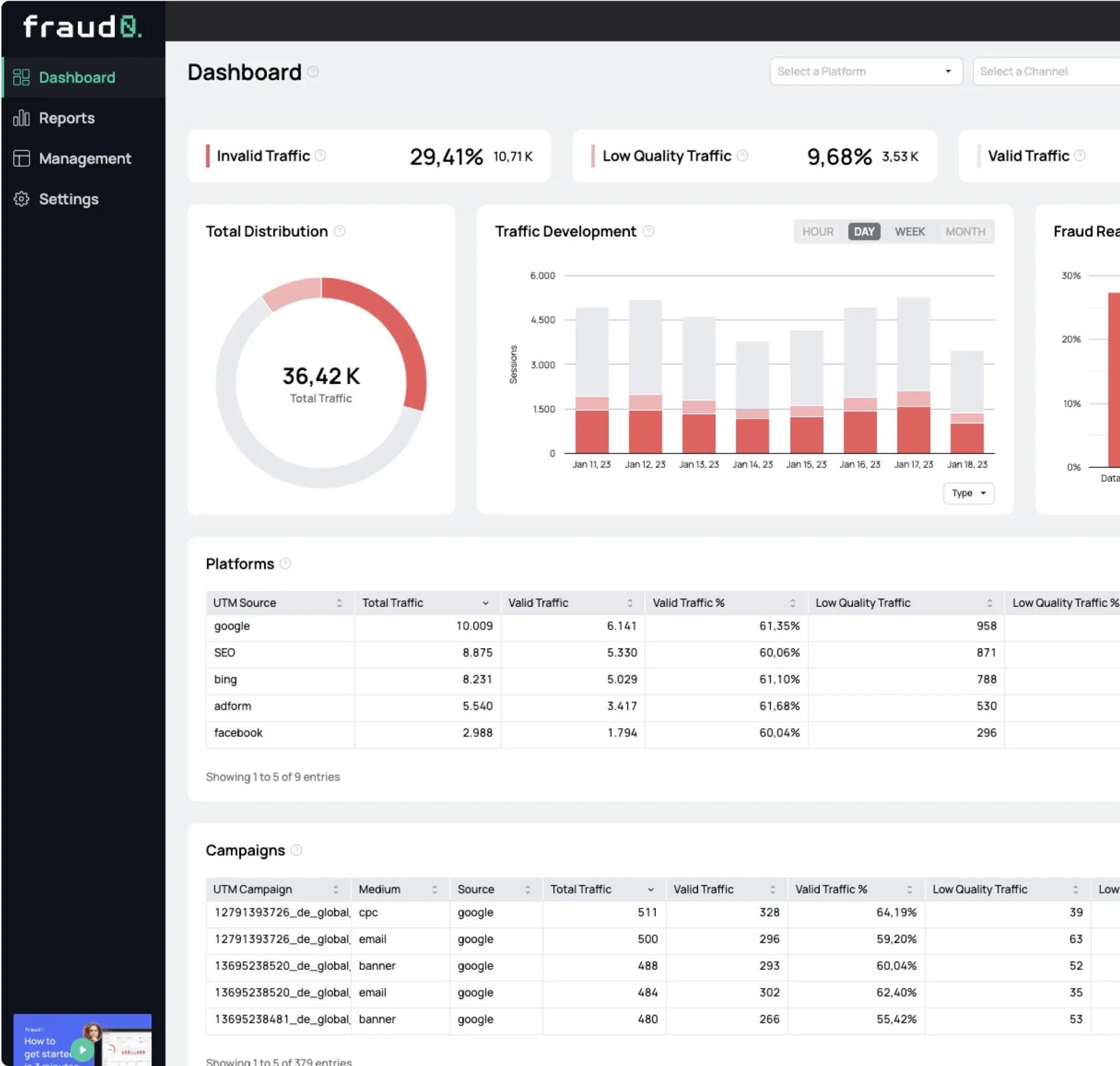

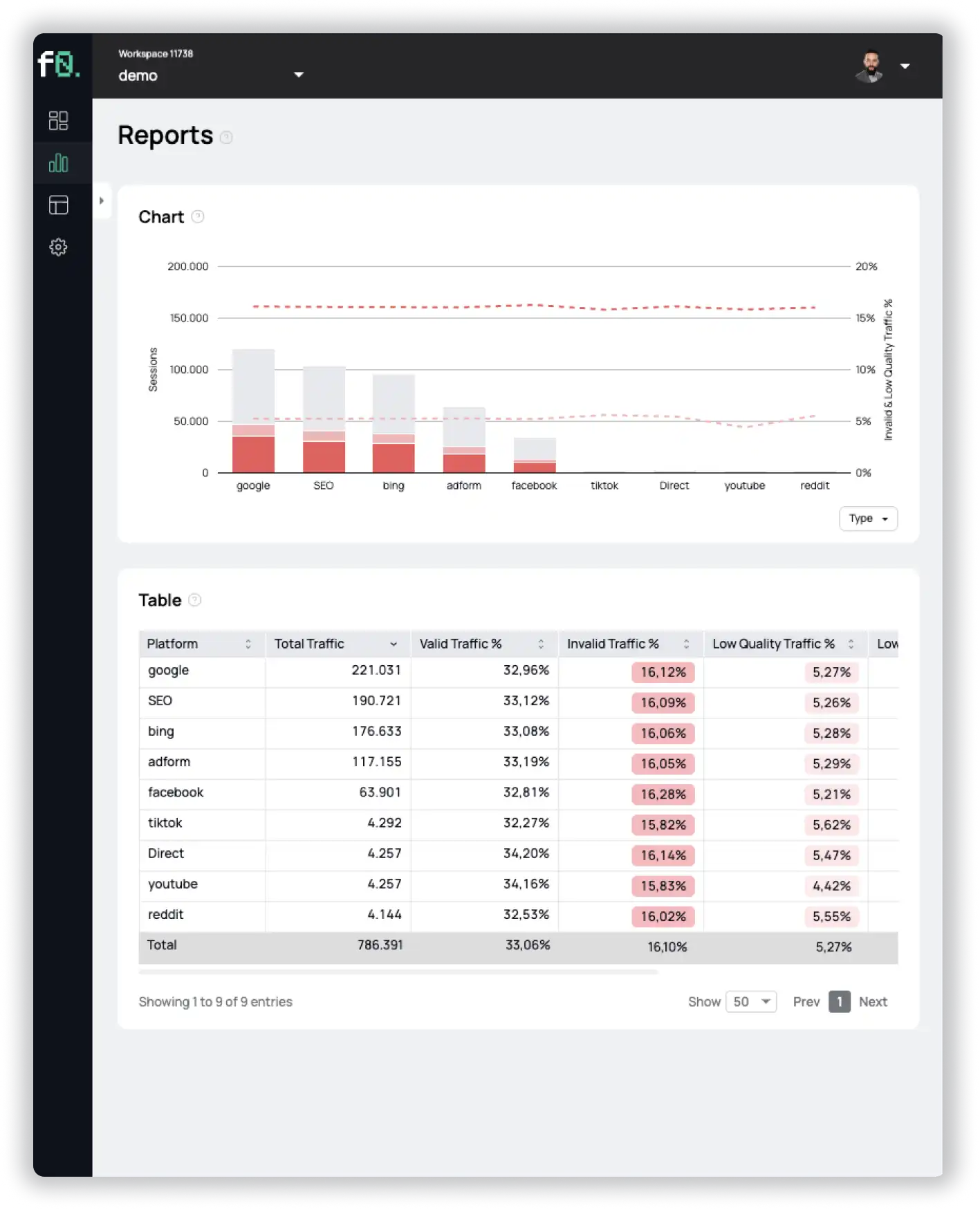

Erfahren Sie alles, was Sie über Invalid Traffic 2024 wissen müssen, basierend auf den Daten unserer Kunden. Einschließlich einer Aufschlüsselung nach Marketingkanälen, Branchen und vielem mehr.

1%, 4%, 36%?